NVIDIA最新GPU带动,液冷服务器市占有望从1%提升到15%的趋势解读

最近,Supermicro推出可立即部署式液冷型AI数据中心。此数据中心专为云原生解决方案而设计,通过SuperCluster加速各界企业对生成式AI的运用,并针对NVIDIA AI Enterprise软件平台优化,适用于生成式AI的开发与部署。

Supermicro的SuperCluster解决方案针对LLM训练、深度学习以及大规模与大批量推理优化Supermicro的SuperCluster支持NVIDIA AI Enterprise,其中包括NVIDIA NIM微服务和NVIDIA NeMo平台,能实现端对端生成式AI客制,并针对NVIDIA Quantum-2 InfiniBand以及具有每GPU 400Gb/s网速的新型NVIDIA Spectrum-X以太网络平台优化,可扩展到具有数万个GPU的大型计算丛集。

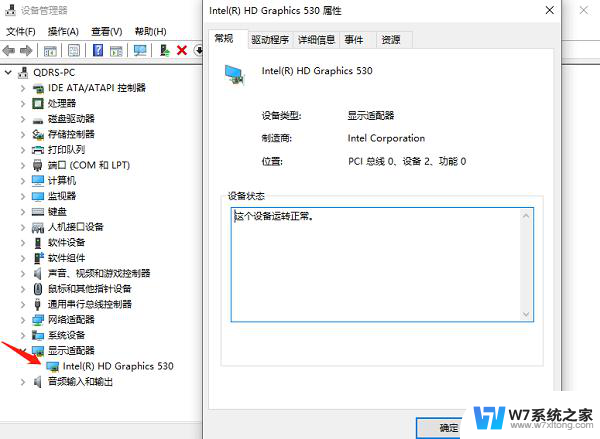

通过Supermicro的4U液冷技术,NVIDIA近期推出的Blackwell GPU能在单一GPU上充分发挥20 PetaFLOPS的AI性能,且与较早的GPU相比,能提供4倍的AI训练性能与30倍的推理性能,并节省额外成本。

Supermicro总裁兼首席执行官梁见后表示,我们的解决方案针对NVIDIA AI Enterprise软件优化,满足各行各业的客户需求,并提供世界规模级效率的全球制造产能。因此我们得以缩短交付时间,更快提供搭配NVIDIA HGX H100和H200,以及即将推出的B100、B200和GB200解决方案的可立即使用型液冷或气冷计算丛集。

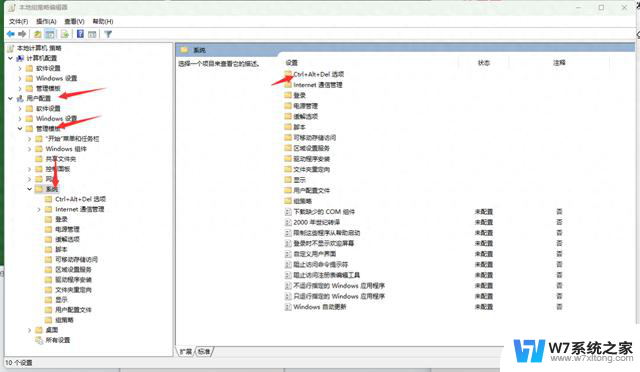

液冷型被越来越多的采用

液冷型被越来越多的采用Supermicro提供的数据中心的液冷配置设计可几近免费,并通过能持续降低用电量的优势为客户提供额外价值。采用液冷方案的整体拥有成本将非常可观,例如来自于后期运营过程当中的电力消耗的减少,5年可以节省高达6000万美元的电费支出。Supermicro从液冷板到CDU乃至冷却塔,其机柜级全方位液冷解决方案最大可以降低数据中心40%的持续用电量。

液冷并非新的技术,它存在已经超过30年,不过在采访中,梁见后表示,之前液冷方案需求量小,并且交期长约4-12个月,以小型OEM为主。如今,Supermicro与客户重新进行子系统和组件设计来提升数据中心的性能,并改善了交期,满足更快的交付要求。

今年以来,客户要求新建数据中心时直接采用液冷方案,也希望将旧有的气冷数据中心部分转换成液冷配置。在此需求刺激下,公司液冷业务的增长非常快,产能处于供不应求的状态。

公司在荷兰、美国和马来西亚等全球各地扩大生产规模,预计2-3个月内马来西亚新厂区即可投产。产能爬坡,供应能力增加,令客户享受更低成本的初始投资方案以及更低的总拥有成本。

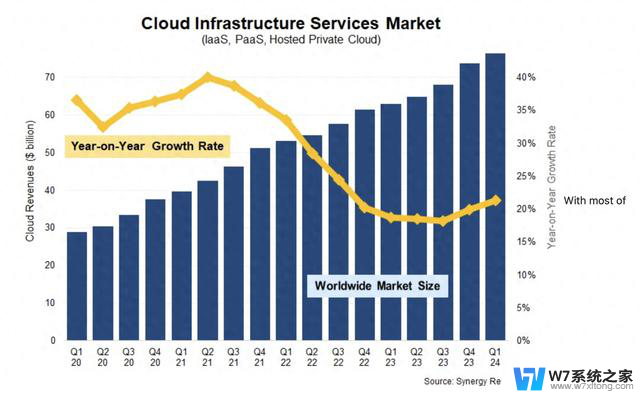

随着大语言模型的服务器集群的需求增长,液冷方案有望成为主流。过去三十年液冷的市场份额估计都不到1%,但数据中心对液冷方案的采用逐渐增多,这一市占有望提高到15%以上。

不断拓展液冷型产品线NVIDIA创始人兼首席执行官黄仁勋对于Supermicro的设计给出高度评价,他表示生成式AI正在推动整个计算堆栈的重置,新的数据中心将会通过GPU进行计算加速,并针对AI优化。Supermicro设计了顶尖的NVIDIA加速计算和网络解决方案,使价值数兆美元的全球数据中心能够针对AI时代优化。

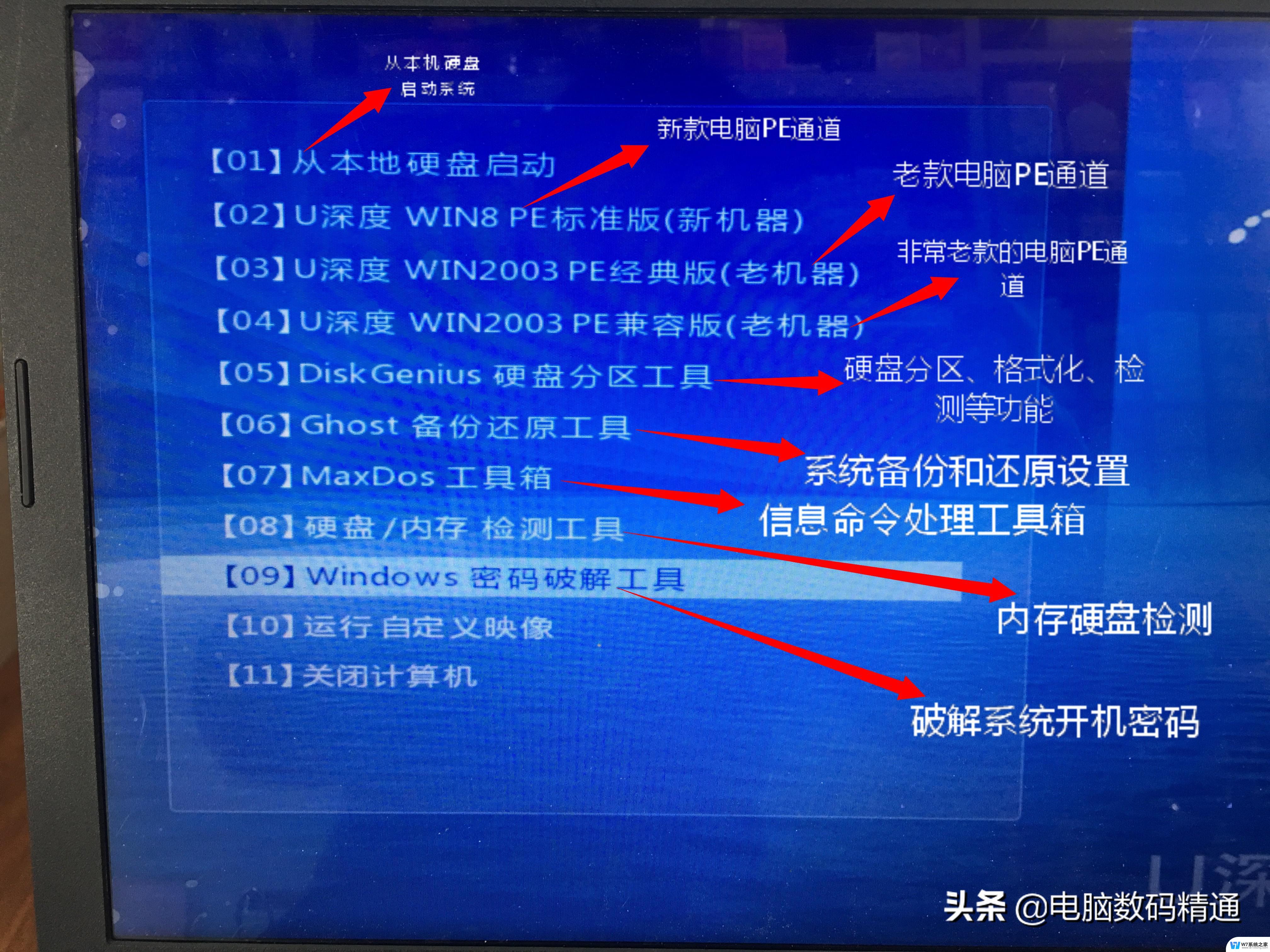

Supermicro目前的生成式AI SuperCluster液冷型产品包括Supermicro NVIDIA HGX H100/H200 SuperCluster,具有256个H100/H200 GPU,为5个机柜规模的可扩展计算单元(包括 1 个专用网络机柜)。即将推出的SuperCluster液冷型产品包括Supermicro NVIDIA HGX B200 SuperCluster液冷型,Supermicro NVIDIA GB200 NVL72 或 NVL36 SuperCluster液冷型。

当然除了液冷型之外,也推出了气冷型产品。例如气冷型Supermicro NVIDIA HGX H100/H200 SuperCluster,具有256个HGX H100/H200 GPU,为9个机柜规模的可扩展计算单元(包括1个专用网络机柜),以及后续将推出的Supermicro NVIDIA HGX B100/B200 SuperCluster气冷型。

Supermicro是主流的AI 服务器制造商之一。受益于 ChatGPT 引发的人工智能热潮,再加上与英伟达的密切合作,这两年Supermicro业绩飙升,并受到资本市场的追捧。如今,Supermicro的液冷服务器技术直击 AI 处理器功耗高的痛点,技术创新和产能提升下,公司的液冷服务器业务将成为强劲的成长动力。